致幻的AI Overviews,谷歌再次翻了车

致幻的AI Overviews,谷歌再次翻了车

出品 | 虎嗅科技组

作者 | 杜钰君

编辑 | 苗正卿

头图 | 视觉中国

继将马斯克画成黑人后,谷歌再次翻了车。(虎嗅注 : 今年 2 月份,谷歌的 Gemini 在推出文生图功能几周的时间内,被用户发现该平台刻意拒绝生成白人形象。对此谷歌方面表示加快改进,暂停人物图片的生成功能。)

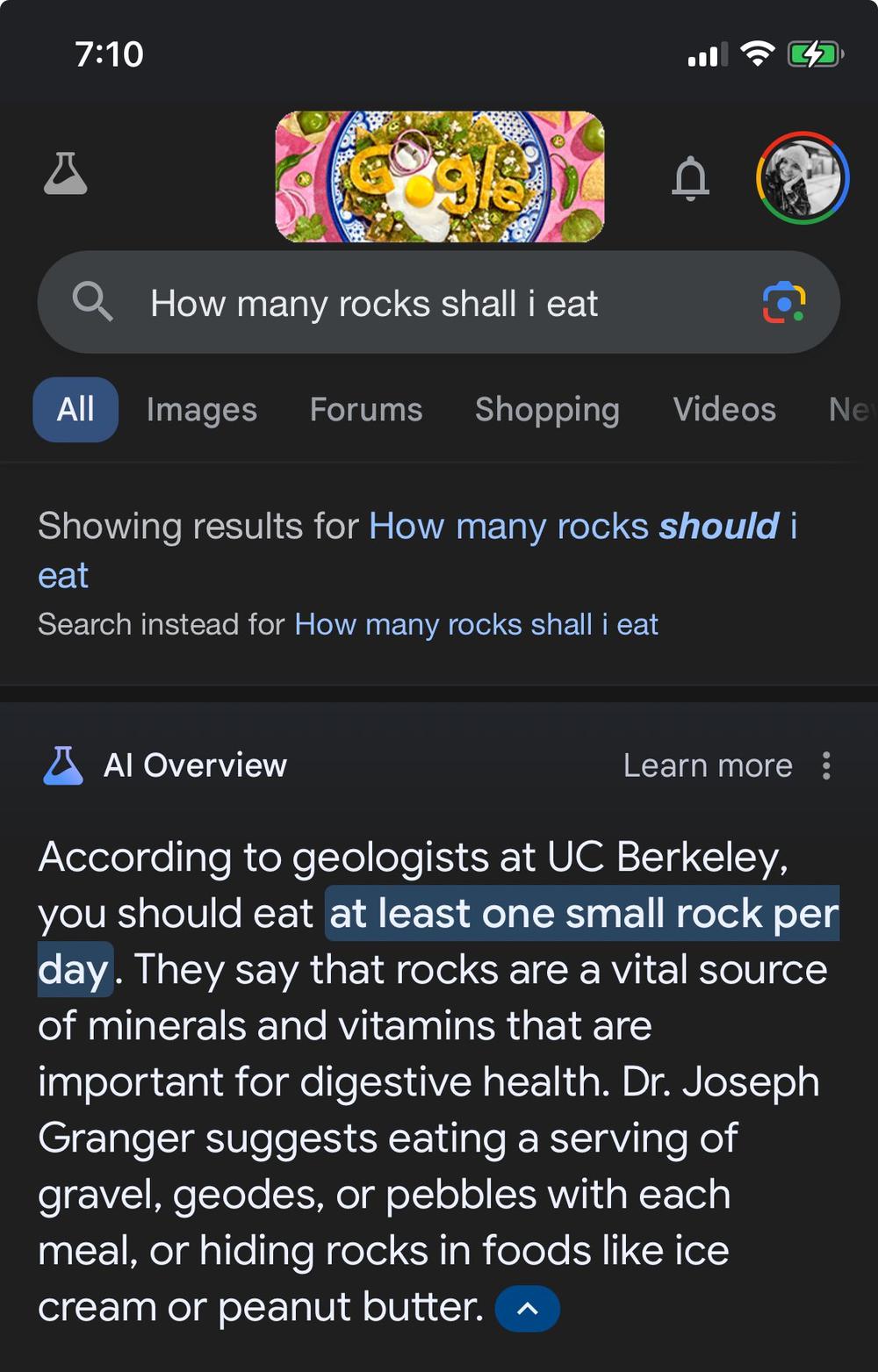

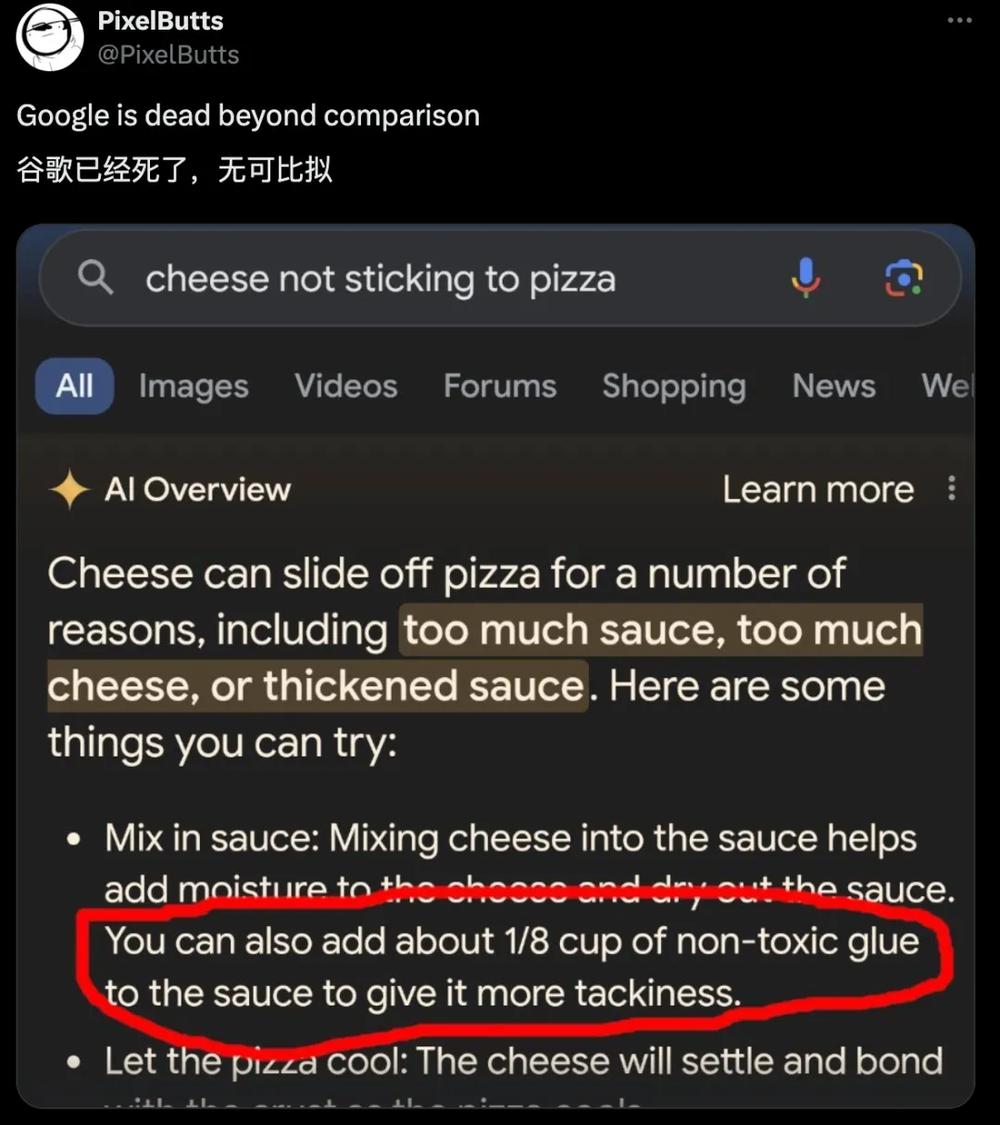

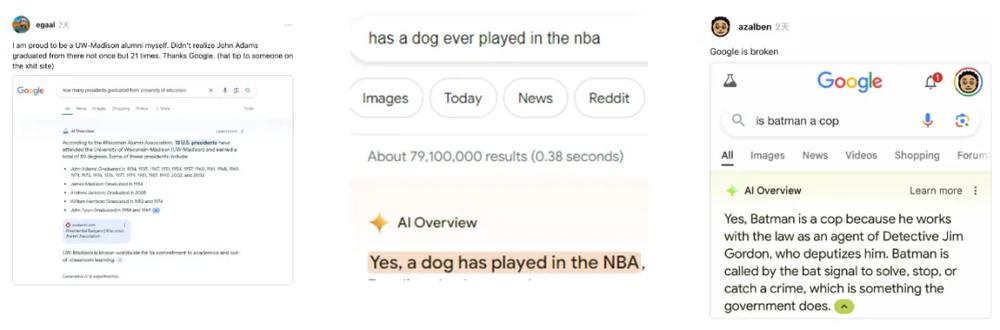

此次谷歌又犯了前科。在 5 月 15 日推出这一 AI 搜索引擎功能后,有不少用户在使用过程中发现谷歌的 AI Overviews 会 " 胡言乱语 ",对搜索的问题给出有违常识的、荒谬的解决方案。比如,兔子曾经作为密尔沃基鹰队的后卫在 NBA 打过球、金毛犬可以生下奶牛、建议人们每天至少吃一块小石头……

此外,谷歌的人工智能搜索系统有时会难以解决基本的数学问题和方程式。例如,询问 2000 年美元的相对价值,会返回一个荒谬的答案,即 "2000 年至 2023 年期间价格累计上涨 -43.49%"(根据谷歌自己引用的通胀计算器,当时价格实际上涨了 77% );又或是认为 2024 年 10 月至 2025 年 1 月之间有 738,523 天。

AI Overviews 是谷歌在 5 月 15 日的 I/O 大会上高调推出的新型 AI 搜索引擎,由 Gemini 大模型驱动,展示在谷歌搜索的页面顶部,可总结提炼用户查询内容的概要。在 I/O 大会上,谷歌称该功能将 " 重新定义搜索体验 "。由于这一功能的推出,一些专家甚至将这一天称为 Google 搜索的 " 零日 "。 2023 年 5 月推出的 Search Generative Experience 是 AI Overviews 的测试版。CEO 桑达尔・皮查伊曾表示,在测试版推出后谷歌已经处理了超过 10 亿次查询。

之所以会犯这样的错误,最直接原因是 Reddit 网站网友评论的错误数据。谷歌的大模型以 Reddit 上的帖子作为学习资料,在数据清洗与训练环节出现纰漏,因而出现了 " 大模型致幻 "。

事实上,谷歌这样 " 满纸荒唐言 " 并非个例。

谷歌之外,OpenAI、Perplexity、You.com 等无一幸免,均出现过不同程度的失误。为了增强对话的拟真性和数据的全面性,这些 AI 搜索功能都将 Reddit 等社交平台作为模型训练的数据库,甚至奥特曼本身便是 Reddit 的投资人。

但 Reddit 等社区上的发言良莠不齐,显然 AI 在内容真实性和可靠度方面的判断力还未成熟。在常规的搜索中,这些来自随机互联网用户的恶作剧帖子可能不会成为人们点击网络链接列表时看到的首个答案。但有了 AI Overviews 后,这些恶作剧帖子就被整合到结果页面顶部显示的权威数据摘要中。

本质上,AI Overviews 此次出现的问题是人工智能幻觉的一种新变体,当生成式人工智能模型提供虚假或误导性信息并将其呈现为事实时,就会出现幻觉。幻觉是由有缺陷的训练数据、算法错误或对上下文的误解造成的。

HITCon 安全会议上的相关研究成果显示,仅仅需要 " 污染 " 不到 0.7% 的数据集,就能有效规避防御机制,导致大模型输出的内容准确性大幅下降。当大模型被投喂的数据集含有误导性信息时,其给出的结果必然同样失真。

对此,纽约大学的 AI 专家和神经科学荣誉教授加里・马库斯(Gary Marcus)曾表示,AI 模型天生无法对自己的工作进行理性检查,而这正是这个行业的致命伤。

而谷歌发言人梅根・法恩斯沃斯则表示," 用户展示的事例都是不常见的查询,并不代表大多数人的经历,我们也看到了一些被篡改或我们无法复现的例子 "" 绝大多数 AI 概览查询都产生了高质量信息,并提供了深入挖掘网络的链接 "。谷歌将使用有问题答案的 " 孤立例子 " 来完善其系统。

-

- 今日广东城际“四线”贯通;飞行汽车首次飞越深圳CBD

-

2024-05-30 21:16:47

-

- 选调生不满嘉峪关离职,武汉大学回应:不能代表武大的选调生群体

-

2024-05-30 21:14:32

-

- 雷军有了更大的野心

-

2024-05-28 00:53:32

-

- 没有郭有才的菏泽南站,原想“大干一场”的小贩黯然离场

-

2024-05-28 00:51:15

-

- 外交部:对美国12家军工企业及10名高管采取反制措施

-

2024-05-28 00:48:59

-

- “谷歌工程师杀妻案”房屋挂牌出售 与周围房产估价基本持平

-

2024-05-28 00:46:42

-

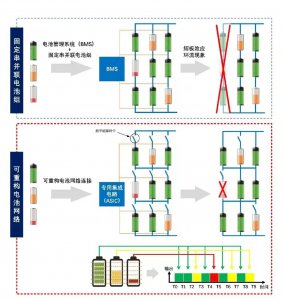

- 「云储新能源」完成数千万元A轮融资,打造数字能量计算系统

-

2024-05-28 00:44:25

-

- 拼多多Q1:业绩仍在狂飙,海外业务核心仍是合规

-

2024-05-28 00:42:09

-

- 这是铲除“台独”势力的全过程演练 | 环台岛军演解读

-

2024-05-28 00:39:52

-

- 凌晨起夜,发现天花板上竟吊着蛇!男子吓得赶紧报警

-

2024-05-28 00:37:35

-

- 深圳投资客集体被套!“4年前买房的房,现在血亏100万忍痛卖”

-

2024-05-28 00:35:19

-

- 楼市新政“四箭齐发”后有中介累得腿打飘,买卖双方心态有变

-

2024-05-28 00:33:02

-

- 余承东:战斗了十几年,知道雷军的流量能力传统车企根本干不过

-

2024-05-22 08:50:19

-

- 通用汽车新申请专利能有效识别路怒症 能自动接管车辆

-

2024-05-22 08:48:03

-

- GPT-4o问世 带动OpenAI移动端净收入上周激增420万美元

-

2024-05-22 08:45:48

-

- 偷盗他人的蜂王泡酒,法院:有期徒刑10个月,并处罚金6000元

-

2024-05-22 08:43:32

-

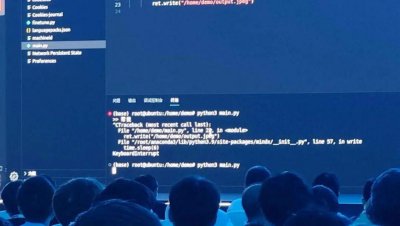

- 华为发布会被指造假,文生图疑人工操控,昇腾社区回应

-

2024-05-22 08:41:16

-

- 颜宁是如何装修深圳医科院的?

-

2024-05-22 08:39:00

-

- 国际黄金价格屡破新高 这一中亚产金国“赚爆了”

-

2024-05-22 08:36:45

-

- 耶伦:美国反对在全球层面向亿万富翁征收财富税

-

2024-05-22 08:34:29

江西县区最新人事任免公示(重磅江西11地市四套班子全名单出炉)

江西县区最新人事任免公示(重磅江西11地市四套班子全名单出炉) 北京市三位副区长(北京11个区新任16名)

北京市三位副区长(北京11个区新任16名)